PythonでCSVをデータベースに書き込む方法:初心者向けガイド

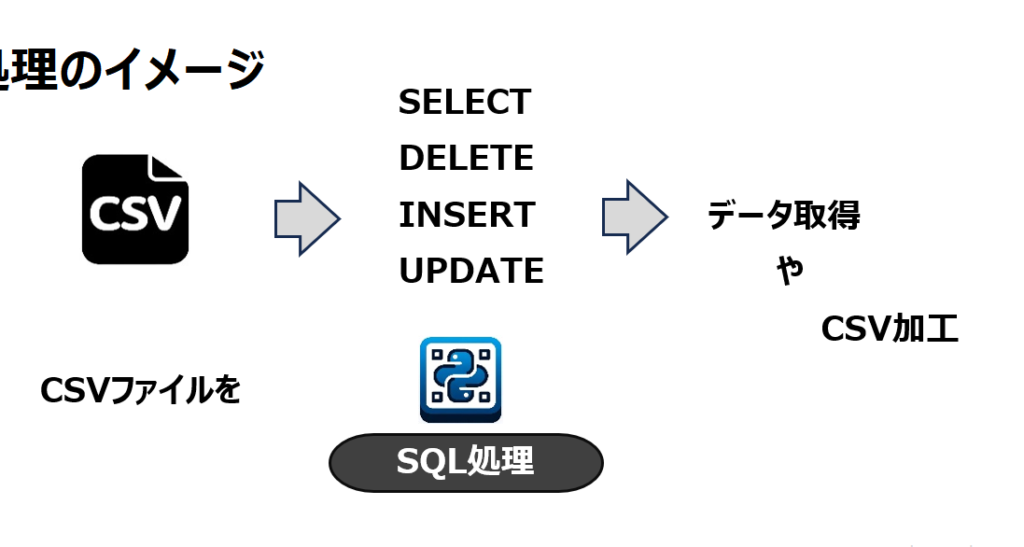

この記事では、Pythonを使ってCSVファイルのデータをデータベースに書き込む方法を解説します。特に、初心者向けに、必要なライブラリのインストールから、データベースへの接続、テーブルの作成、データの挿入、そして接続のクローズまでを段階的に説明します。CSVはデータの保存や交換に広く使われる形式ですが、データベースにインポートすることで、より効率的なデータ管理や分析が可能になります。このガイドを通じて、SQLiteやPostgreSQLなどのデータベースにCSVデータを簡単に取り込む手順を学びましょう。

イントロダクション

Pythonを使ってCSVファイルをデータベースに書き込む方法は、データ処理や分析を行う上で非常に重要なスキルです。CSVはシンプルな形式でありながら、大量のデータを扱うのに適しています。しかし、データを効率的に管理し、クエリを実行するためには、データベースに保存することが望ましい場合があります。このガイドでは、Pythonを使ってCSVデータをデータベースにインポートする手順を、初心者向けにわかりやすく解説します。

まず、CSVファイルを読み込むために必要なライブラリと、データベースに接続するためのライブラリをインストールします。Pythonには標準でcsvモジュールが含まれており、CSVファイルの読み書きが簡単に行えます。また、データベース接続には、SQLiteを使用する場合はsqlite3、PostgreSQLを使用する場合はpsycopg2といったライブラリが必要です。これらのライブラリを利用することで、データベースとのやり取りがスムーズに行えます。

次に、データベースへの接続設定を行います。データベースの種類に応じて、接続文字列や認証情報を指定します。SQLiteの場合はファイルパスを指定するだけで簡単に接続できますが、PostgreSQLやMySQLなどの外部データベースを使用する場合は、ホスト名、ポート番号、ユーザー名、パスワードなどの情報が必要です。接続が確立されたら、テーブルを作成し、CSVデータを挿入する準備が整います。

CSVファイルの読み込みとデータベースへの書き込みは、ループ処理を使って行います。CSVファイルの各行を読み取り、データベースのテーブルに挿入するクエリを実行します。この際、データの整合性を保つために、適切なデータ型を指定することが重要です。最後に、変更を確定するためにコミットを行い、データベース接続をクローズします。これで、CSVデータがデータベースに無事に保存されます。

必要なライブラリのインストール

PythonでCSVデータをデータベースに書き込むためには、まず必要なライブラリをインストールする必要があります。csvモジュールはPythonの標準ライブラリに含まれているため、追加のインストールは不要です。しかし、データベースとの接続や操作を行うためには、sqlite3やpsycopg2といったライブラリが必要です。sqlite3はPythonに標準で含まれていますが、PostgreSQLなどの他のデータベースを使用する場合は、psycopg2をインストールする必要があります。これらのライブラリは、pipコマンドを使って簡単にインストールできます。例えば、pip install psycopg2と実行することで、PostgreSQL用のライブラリをインストールできます。ライブラリのインストールが完了したら、次のステップに進む準備が整います。

データベース接続の設定

データベースにCSVデータを書き込むためには、まずデータベース接続の設定を行う必要があります。Pythonでは、データベースの種類に応じて異なるライブラリを使用します。例えば、SQLiteを使用する場合はsqlite3、PostgreSQLを使用する場合はpsycopg2といったライブラリを利用します。これらのライブラリをインストールした後、データベースへの接続を確立します。接続には、データベースのホスト名、ポート番号、ユーザー名、パスワードなどの情報が必要です。これらの情報を正しく設定することで、Pythonからデータベースにアクセスできるようになります。

接続が確立されたら、次にカーソルオブジェクトを作成します。カーソルは、データベースに対してSQLクエリを実行するための重要なツールです。カーソルを使用して、テーブルの作成やデータの挿入などの操作を行います。接続設定が完了したら、CSVファイルの読み込みとデータベースへの書き込みに進む準備が整います。この段階で、データベースの構造やCSVファイルの形式を確認しておくことが重要です。これにより、スムーズにデータを移行することができます。

CSVファイルの準備

CSVファイルをデータベースに書き込むためには、まずCSVファイルの準備が重要です。CSVファイルは、データがカンマで区切られたテキストファイルであり、データベースにインポートするためのデータソースとして広く利用されています。ファイルが正しくフォーマットされているか確認し、必要なデータが含まれていることを確認しましょう。特に、ヘッダー行が存在する場合、データベースのテーブルカラムと一致するか確認することが重要です。

次に、CSVファイルのエンコーディングを確認します。日本語を含むデータを扱う場合、UTF-8などの適切なエンコーディングが使用されているか確認しましょう。エンコーディングが異なると、データの読み込み時に文字化けが発生する可能性があります。また、ファイル内に不要な空白や特殊文字が含まれていないかもチェックし、必要に応じてクリーニングを行います。

最後に、CSVファイルのパスを確認し、Pythonスクリプトからアクセス可能な場所に配置します。これにより、後続の手順でスムーズにファイルを読み込むことができます。ファイルパスが正しく設定されていないと、エラーが発生するため、注意が必要です。

CSVファイルの読み込み

CSVファイルを読み込むためには、Pythonの標準ライブラリであるcsvモジュールを使用します。このモジュールを使うことで、CSVファイルの内容を簡単に読み取り、Pythonのデータ構造として扱うことができます。まず、open()関数を使ってCSVファイルを開き、csv.reader()関数を使ってファイルの内容を読み込みます。これにより、CSVファイルの各行がリストとして取得され、プログラム内で処理できるようになります。

csv.reader()を使う際には、ファイルのエンコーディングや区切り文字を指定することも可能です。特に、日本語を含むCSVファイルを扱う場合、エンコーディングをutf-8に設定することが重要です。また、CSVファイルの1行目がヘッダー行である場合、next()関数を使ってヘッダーをスキップし、データ部分だけを読み込むこともできます。これにより、データベースに挿入する際に不要な情報を除外できます。

読み込んだデータは、リストや辞書などのデータ構造として扱うことができます。例えば、csv.DictReader()を使うと、各行が辞書形式で取得され、列名をキーとしてデータにアクセスできます。これにより、データベースへの挿入がより直感的に行えるようになります。CSVファイルの読み込みが完了したら、次のステップとしてデータベースへの接続とテーブルの作成に進みます。

データベースへの接続

データベースに接続するためには、まずデータベースドライバをインストールする必要があります。例えば、SQLiteを使用する場合はPythonに標準で含まれるsqlite3モジュールを利用できますが、PostgreSQLやMySQLなどの他のデータベースを使用する場合は、psycopg2やmysql-connector-pythonなどの外部ライブラリをインストールする必要があります。これらのライブラリは、Pythonからデータベースに接続し、操作するためのインターフェースを提供します。

接続を確立するには、データベースの接続情報が必要です。これには、データベースのホスト名、ポート番号、データベース名、ユーザー名、パスワードなどが含まれます。例えば、SQLiteの場合はデータベースファイルのパスを指定するだけで接続できますが、PostgreSQLやMySQLの場合はこれらの情報を全て指定する必要があります。接続が成功すると、カーソルオブジェクトが作成され、これを使ってSQLクエリを実行できます。

接続が確立されたら、テーブルの作成やデータの挿入などの操作を行う準備が整います。データベースへの接続は、リソースを適切に管理するために、操作が終了したら必ずクローズすることが重要です。これにより、接続が確実に解放され、リソースの無駄遣いを防ぐことができます。

テーブルの作成

テーブルの作成は、CSVデータをデータベースに書き込むための重要なステップです。まず、データベースに接続した後、適切なテーブル構造を設計する必要があります。テーブルは、CSVファイルの各列に対応するカラムを持つように作成します。例えば、CSVファイルに「名前」「年齢」「住所」の列がある場合、テーブルにも同じ名前のカラムを定義します。カラムのデータ型は、CSVデータの内容に応じて適切に選択することが重要です。例えば、文字列データにはVARCHAR、数値データにはINTEGERやFLOATを使用します。

テーブルを作成する際には、SQLのCREATE TABLE文を使用します。この文では、テーブル名と各カラムの定義を指定します。例えば、CREATE TABLE users (id INTEGER PRIMARY KEY, name VARCHAR(50), age INTEGER, address VARCHAR(100));のように記述します。この例では、usersというテーブルを作成し、id、name、age、addressという4つのカラムを定義しています。idカラムは主キーとして設定され、自動的に一意の値が割り当てられます。

テーブルが正しく作成されたか確認するために、データベースのスキーマを確認することができます。SQLiteではPRAGMA table_info(users);、PostgreSQLではd usersといったコマンドを使用して、テーブルの構造を確認できます。テーブルの作成が完了したら、次のステップとしてCSVデータをテーブルに挿入する準備が整います。

CSVデータの挿入

CSVデータの挿入は、データベースに情報を効率的に取り込むための重要なステップです。まず、csvモジュールを使用してCSVファイルを読み込みます。このモジュールは、CSVファイルの各行を簡単に処理できるようにするための便利なツールです。ファイルを開き、csv.readerを使って各行をイテレートすることで、データをプログラム内で扱いやすい形に変換できます。

次に、データベースに接続し、SQLクエリを使用してテーブルを作成します。テーブルの構造は、CSVファイルの列に合わせて設計する必要があります。例えば、CSVファイルに「名前」「年齢」「住所」の列がある場合、データベースのテーブルもこれらの列に対応するフィールドを持つようにします。テーブルが準備できたら、CSVから読み取ったデータをINSERT文を使ってデータベースに挿入します。この際、各レコードをループで処理し、適切なフィールドにデータを割り当てることが重要です。

最後に、コミットを行って変更を確定し、データベース接続をクローズします。これにより、CSVデータがデータベースに正しく保存され、後続の処理や分析が可能になります。このプロセスは、データの整合性を保ちながら、大量の情報を効率的に管理するための基本的な手法です。

変更のコミット

データベースへの変更を確定するためには、コミットという操作が必要です。コミットは、データベースに対して行った変更を永続的に保存するための重要なステップです。Pythonでは、commit()メソッドを使用してこの操作を行います。例えば、SQLiteデータベースを使用している場合、connection.commit()を呼び出すことで、それまでに行った挿入や更新がデータベースに反映されます。

コミットを行わない場合、データベースへの変更は一時的なものとなり、プログラムが終了すると変更が失われてしまいます。特に、大量のデータを扱う場合や、重要なデータを扱う場合には、コミットを忘れないように注意が必要です。また、エラーが発生した場合に変更を取り消すために、ロールバックを行うことも可能です。これにより、データの整合性を保つことができます。

最後に、データベースとの接続を閉じる前に、必ずコミットを実行することを忘れないでください。これにより、データベースへの変更が確実に保存され、後続の処理で問題が発生することを防ぐことができます。

データベース接続のクローズ

データベースへのデータ挿入が完了したら、最後にデータベース接続をクローズすることが重要です。接続をクローズしないと、リソースが解放されず、メモリリークやパフォーマンスの低下を引き起こす可能性があります。Pythonでは、close()メソッドを使用して簡単に接続を閉じることができます。特に、SQLiteやPostgreSQLなどのデータベースを使用する場合、接続を適切に管理することは、アプリケーションの安定性を保つために不可欠です。

また、withステートメントを使用することで、接続のクローズを自動化することもできます。withブロック内でデータベース操作を行うと、ブロックを抜けた時点で自動的に接続がクローズされます。これにより、リソース管理が簡素化され、コードの可読性も向上します。特に初心者の方は、この方法を活用することで、接続のクローズ忘れを防ぐことができます。

最後に、データベース接続をクローズする前に、必ずコミットが行われていることを確認してください。コミットを行わないと、データベースへの変更が保存されないため、せっかく挿入したデータが失われる可能性があります。これらの手順をしっかりと守ることで、効率的で安全なデータベース操作を実現できます。

まとめ

Pythonを使用してCSVデータをデータベースに書き込む方法を理解することは、データ管理の重要なスキルです。このガイドでは、CSVファイルを読み込み、データベースに接続し、データを効率的にインポートする手順を説明します。まず、必要なライブラリをインストールし、データベース接続の設定を行います。次に、CSVファイルを読み込み、データベースにテーブルを作成してデータを挿入します。最後に、変更をコミットし、データベース接続をクローズします。

このプロセスを通じて、Pythonの強力な機能を活用し、データの管理と分析を効率化することができます。初心者でも簡単に理解できるように、各ステップを詳細に解説しています。このガイドを参考に、CSVデータをデータベースに書き込むスキルを身につけ、プロジェクトに活用してください。

よくある質問

1. PythonでCSVファイルをデータベースに書き込むにはどのようなライブラリが必要ですか?

PythonでCSVファイルをデータベースに書き込むためには、主にcsvモジュールとsqlite3(SQLiteを使用する場合)やpymysql(MySQLを使用する場合)などのデータベース接続ライブラリが必要です。csvモジュールはCSVファイルの読み込みに使用し、データベース接続ライブラリはデータベースとのやり取りに使用します。また、pandasを使用してCSVファイルを読み込み、データフレームとして扱うことも一般的です。これにより、データの前処理や変換が容易になります。

2. CSVファイルをデータベースに書き込む前にデータをどのように前処理すべきですか?

CSVファイルをデータベースに書き込む前に、データのクリーニングやフォーマットの統一が重要です。例えば、欠損値(NaN)の処理、文字列のトリミング、日付形式の変換などを行います。また、データ型の確認も重要で、データベースのカラムに適した型に変換する必要があります。pandasを使用する場合、dropna()やfillna()で欠損値を処理し、astype()でデータ型を変換できます。さらに、重複データの削除や不要なカラムの削除も前処理の一環として行うことが推奨されます。

3. データベースにCSVデータを書き込む際にエラーが発生した場合、どのようにデバッグすべきですか?

データベースにCSVデータを書き込む際にエラーが発生した場合、まずエラーメッセージを確認し、問題の原因を特定します。よくあるエラーとしては、データ型の不一致、主キーの重複、カラム数の不一致などがあります。デバッグのためには、try-exceptブロックを使用してエラーをキャッチし、詳細なログを出力することが有効です。また、CSVファイルの内容を確認し、データベースのスキーマと一致しているかどうかを確認します。必要に応じて、データのサンプルをプリントして確認することも役立ちます。

4. 大量のCSVデータを効率的にデータベースに書き込む方法はありますか?

大量のCSVデータを効率的にデータベースに書き込むためには、バッチ処理やトランザクションの使用が有効です。例えば、sqlite3やpymysqlでは、executemany()メソッドを使用して複数のレコードを一括で挿入できます。また、pandasのto_sql()メソッドを使用する場合、chunksizeパラメータを指定してデータを分割して書き込むことができます。これにより、メモリ使用量を抑えつつ、処理速度を向上させることが可能です。さらに、インデックスの作成や一時的な制約の無効化もパフォーマンス向上に役立ちます。

コメントを残す

コメントを投稿するにはログインしてください。

関連ブログ記事